关于这次爬虫作业

由于学长给的爬虫个人感觉有较为简洁的做法,于是学习了Java的hutool工具以及Remark工具,这样使我们的代码不但省去了很多抓取内容,更提升了可读性(而且正则表达式大幅下降)

那么我们代码的核心部分便是:

HttpRequest.get(...).execute().body()

以及

String href = parse.select("dl > dd:nth-child(" + i + ") > a").attr("href");

还有

String markdown = remark.convertFragment(ff);

他们的作用分别是抓网页,抓细节和转Markdown

下面简略说一下提升体验感的部分

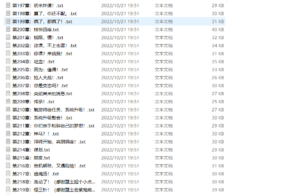

首先我们提供了自定义储存位置,最终的文件也将以txt格式整理储存,而且添加了每隔一段时间汇报进度,下面是随机一篇的整体过程:

然后就到了破防的debug过程,当时加上remark这个依赖以后,一直出一些我看不懂的问题,在我几乎每一行都输出来debug的时候,我到GitHub看了一眼他的代码,然后发现这玩意居然把jsoup给包进去了,最后也是在耗时于无意义方面后顺利解决了

ps:图片在媒体库还是很清楚的,不知道为什么胡了()

八百万神明在我身后